ИИ раскрыт: Google и Яндекс вычисляют нейротексты с точностью 99%

Меня зовут Роман Ковалёв, и последние 18 лет в агентстве я занимаюсь SEO, контекстом, контентом, таргетом, медийкой, аналитикой, разработкой – всем, что делает интернет-бизнес живым и доходным. А последние пару лет – еще и нейросетями.

Сначала я применял их для себя, потом – для агентства, затем в корпоративном обучении, потом в онлайн-курсы, потом уже на конференции, и теперь почти каждый пятый вопрос из зала:

«А правда, что Яндекс и Google банят тексты, написанные нейросетями?»

Оживил эту картинку в 5-секундное видео (смотреть в самом конце)

Если коротко: нет, не банят.

Всё.

Кстати, внизу будет ссылка на видео. Там то же самое, но в формате ролика – чуть подробнее, с презентацией и графиками.

Если кто-то хочет разобраться в вопросе, то давайте пойдем по порядку, так как в этой теме слишком много страха и слишком мало понимания.

Откуда взялась эта паника

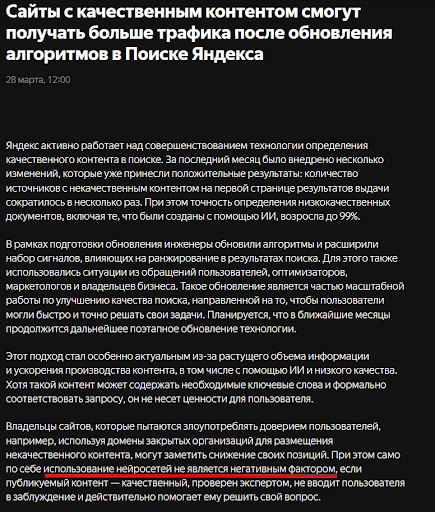

Все началось с новости от Яндекса. В марте 2025 он выкатил обновление и среди прочего заявил:

Мы научились с 99% точностью определять тексты, написанные ИИ.

И началось… Паника, как по сценарию. Вебмастера и SEO-шники бросились переписывать тексты, клиенты начали писать: «А точно ли можно теперь публиковать ИИ-контент?»

Я сидел и читал все это с легким офигеванием. Потому что уже через пару абзацев в этой же новости Яндекс писал буквально следующее:

При этом само по себе использование нейросетей не является негативным фактором, если публикуемый контент – качественный, проверен экспертом, не вводит пользователя в заблуждение и действительно помогает ему решить свой вопрос.

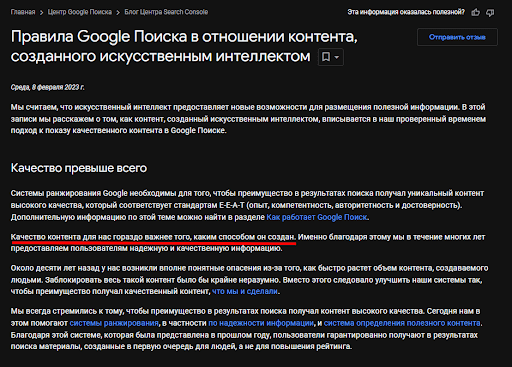

Понимаете? Не «ИИ – плохо», а «бесполезный контент – плохо». А теперь внимание: когда Google год назад выступал с похожим заявлением, он сказал вообще прекрасную фразу:

«Качество контента важнее способа его создания».

То есть ни Google, ни Яндекс не против нейросетей. Они против мусора. А мусор, между прочим, умеет писать не только ChatGPT, но и Вася из соседнего подъезда за 300₽/1000 знаков.

Яндекс

Как работает вся эта «проверка на ИИ» (и почему это не повод для паники)

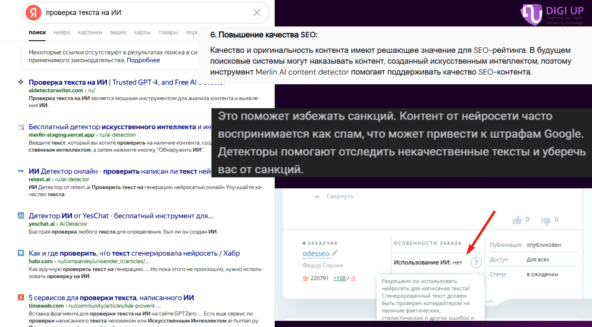

Вы наверняка видели эти сервисы – «определим, писал ли текст человек или машина». У некоторых из них есть даже красивые диаграммы, проценты и уверенные заголовки. А теперь давайте по-честному: я протестировал с десяток таких инструментов – и почти каждый второй раз они выдают бред.

Серьезно. Я даю системе текст, написанный копирайтером вручную – она говорит: «Генеративный». Генерирую статью в ChatGPT, чуть-чуть ее обрабатываю – и мне возвращают: «Текст написан человеком».

Почему так? Да потому что вся эта детекция построена на банальной логике: если в тексте слишком все гладко, последовательно и предсказуемо – значит, наверное, это ИИ. Упрощенно говоря, если после слова «добрый» идет «день», а после «с днем» – «рождения», значит, подозрительно.

Но в таком случае под раздачу попадает не только ИИ, но и любой копирайтер, который пишет по шаблону: вводная, три подзаголовка, два CTA и пример. Все по классике, как учили на курсах. Только вот поисковику и пользователю от такой «уникальности» ни жарко, ни холодно.

Так что повторю ключевую мысль: проблема не в том, кто написал текст, а в том, что он написал. Контент может быть сгенерированным, но если он полезный, структурный, экспертный – все с ним будет хорошо.

Пугальщики

Нейросети – это инструмент, а не угроза

В агентстве у нас есть отдельное направление – нейрокопирайтинг. Это не «тексты, которые полностью пишет ИИ», а нормальная редакционная работа, просто с другим инструментом.

Как мы это делаем:

-

Сначала выстраиваем структуру статьи. Обсуждаем ее с нейросетью: какие блоки, какая последовательность, чего не хватает.

-

Дальше – генерация по частям. Никогда не просим «сделай статью целиком». Один блок – один запрос. Максимум два.

-

Всё, что выходит из нейросети, проходит через человека. Правим, уточняем, дополняем.

-

Техническая доработка: ключи, заголовки, подзаголовки, мета, ссылки.

-

Только потом – публикация.

На выходе получается нормальный, качественный материал. С уникальностью, с фактами, с редактурой. И пользователю полезно, и поисковик доволен.

Так что если кто-то говорит «ИИ нельзя использовать» – чаще всего он просто не умеет им пользоваться.

Когда ИИ действительно может угробить ваш сайт

Теперь давайте поговорим об обратной стороне. Потому что, несмотря на все выше сказанное, да – можно легко влететь в фильтры. Причем даже не заметив этого.

Вот как это происходит:

Вы берете шаблон статьи «Что такое X и зачем он нужен», генерируете через ChatGPT сто штук таких текстов – и грузите на сайт. Потом удивляетесь. Торг, отчаяние, принятие и пр.

Ответ простой: потому что это мусор. Даже если он уникальный технически. Даже если он без ошибок. Потому что поисковик оценивает не только оригинальность текста, но и его полезность.

-

Что нового ты сказал?

-

Что объяснил?

-

Кому это вообще поможет?

Раньше эту практику называли синонимайзингом – когда текст переписывали вручную с минимальными изменениями, лишь бы было «не как у всех». Теперь просто вместо индусов за 30 рублей/1000 знаков это делает нейросеть. Суть не поменялась.

А алгоритмы Яндекса и Google за последние два года научились такой контент отсеивать очень хорошо. Причем делают это не потому, что он написан ИИ, а потому что он бесполезен.

Как правильно: нейросеть + человек = нормальный результат

Если вы думаете, что работа с ИИ – это «вставил запрос – получил статью – выложил» – то да, ваш контент в зоне риска. Но если вы относитесь к этому как к редакторскому инструменту, результат будет выше среднего.

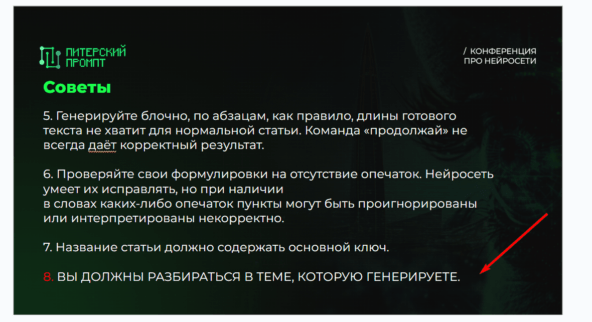

Я всегда говорю своим студентам, коллегам и слушателям на конференциях, где выступаю: неважно, пишешь ты руками или генерируешь – если ты не понимаешь тему, хорошего текста не будет. Хочешь писать про крипту? Разберись в крипте. Пишешь про юридические услуги? Проконсультируйся с юристом.

Если не хватает экспертизы – бери интервью, собирай кастдев, делай редактуру с привлечением эксперта. И только потом подключай нейросеть – чтобы ускорить, структурировать и усилить.

Как повысить доверие поиска (и не попасть под фильтр)

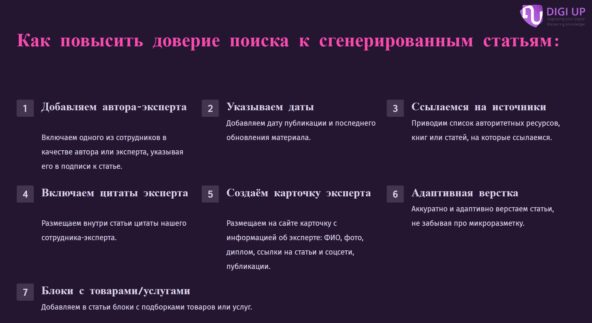

Окей, вы сгенерировали текст, проверили, дописали, отредактировали. Что дальше? Просто опубликовать – недостаточно. Поисковики смотрят не только на содержание, но и на контекст: оформление, авторство, структуру страницы. И вот здесь многие сливаются.

Вот что я делаю сам и советую всем:

-

Укажите автора

Не «Редакция» и не «Информационный отдел». Конкретный человек. Даже если этот человек – вы сами. Укажите ФИО, добавьте фотографию, ссылки на соцсети и публикации. Почему? Потому что авторство – это сигнал: за этим текстом стоит человек, который берет на себя ответственность.

-

Добавьте цитаты экспертов

Если в статье фигурирует мнение специалиста – выделите его. Цитата, имя, должность, контекст. Это повышает достоверность материала в глазах и пользователя, и алгоритма.

-

Покажите дату

Дата публикации и (если есть) дата обновления. Особенно важно для статей, где информация быстро устаревает. И особенно – если вы что-то меняете. Обновили – покажите, когда.

-

Дайте источники

Если вы приводите факты, цифры, мнения – будьте честны, укажите, откуда это. Ссылки на авторитетные ресурсы – не балласт, а часть стратегии.

-

Сделайте нормальную верстку

Статья должна удобно читаться. Особенно с телефона. Не надо лепить полотна текста, делайте подзаголовки, списки, таблицы, вставки. Плюс – оформляйте все через микроразметку: это помогает красиво отображаться в поиске.

-

Добавьте коммерческий блок

Если вы пишете статью для продвижения товаров или услуг – не прячьте это. Добавьте подборку, форму, попап, баннер. Не мешайте, а дополняйте.

Всё это – не какие-то суперсекретные приемы. Это просто нормальная культура публикации, которая сейчас стала требованием рынка.

Как это работает на практике: реальный кейс

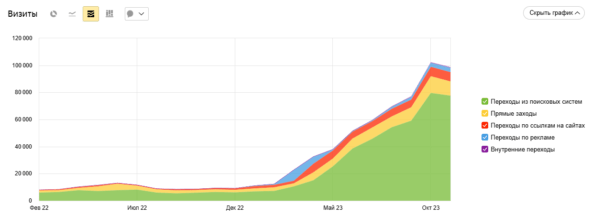

Чтобы не быть голословным – пример из практики агентства.

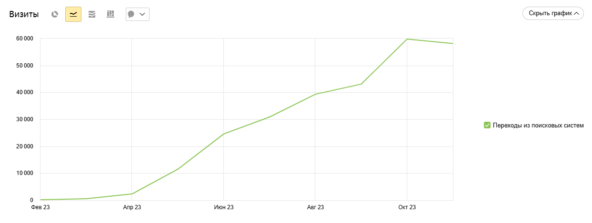

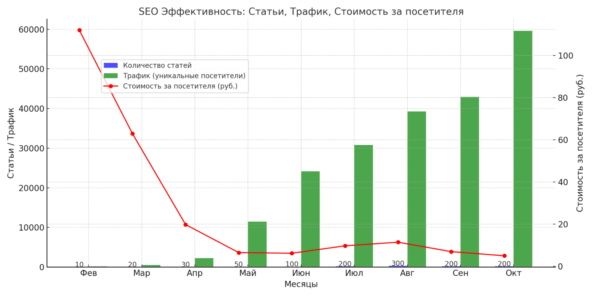

Один из клиентов пришел с сайтом, где было 5 000 переходов в месяц. Контент – почти отсутствует, трафик не растет. В феврале мы начали писать статьи – строго по методике: структура, генерация по блокам, редактура, публикация.

И пошло.

Причем, чтобы не было иллюзий – мы помечали нейростатьи специальными UTM-метками. Прямо отслеживали трафик именно на них. И да, именно они давали основной рост.

А теперь вишенка на торте: стоимость перехода.

Да, мы потом часть переработали, пришлось дооптимизировать поведенческие, кое-что переписали. Но в целом: результат есть. И он закономерен.

Пример далеко не единичный, уже что-то около 50-60 сайтов содержат нами сделанный с помощью нейросетей контент.

Выводы

Поисковики умеют определять тексты, написанные ИИ. Но не фильтруют их просто за факт генерации. Фильтруют – за бесполезность.

Так что бояться нейросетей – бессмысленно. Надо просто научиться ими пользоваться.

Если вы умеете – будет дешевле, быстрее, эффективнее. Если не умеете – будет фильтр, ноль трафика и разочарование.

И это, кстати, касается не только текстов. Нейросети становятся источником трафика сами по себе – уже видно, как растет количество переходов из ChatGPT, Perplexity и других. Это не враг. Это новая площадка. Новый поисковик)

А вот и обещанное видео:

-

ВК

-

Рутуб (не ржать, там за год уже 24 подписчика!)

Оригинал статьи на SEOnews